inference

US /ˈɪnfərəns/

・UK /ˈɪnfərəns/

B1 中級TOEIC

n. (u.)不可算名詞推論

The inference was that sunlight makes plants grow

n. (u.)不可算名詞暗示

Going to the park instead of the cinema was an inference from my twin

動画字幕

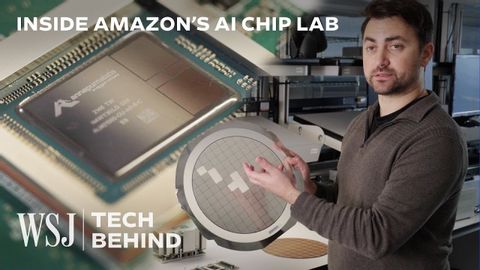

AIチップの製造現場に潜入|WSJ Tech Behind (Inside the Making of an AI Chip | WSJ Tech Behind)

06:29

- Amazon makes two different AI chips, named for its two essential functions, training and inference.

アマゾンは2つの異なる AI チップを製造しており、その2つの重要な機能、トレーニングと推論にちなんで名付けられました。

- Inference is when it uses that training to actually generate an original image of a cat.

推論とは、その学習を使って実際に猫のオリジナル画像を生成することです。

SketchUpを使い始める - パート2 (Getting started with SketchUp - Part 2)

08:12

- we are interested in this inference point. Once you see the tool tip telling you it's

これで推定点が認識されます 黄色のラベルで中点が表示されたら

- for a few moments and as you continue to draw you'll see a new inference that is purple

上のエッジで少し止めてからまた動かすと 新しい紫の線が表示されます

Part 7二都物語(Book 03, Chs 08-11) (Part 7 - A Tale of Two Cities Audiobook by Charles Dickens (Book 03, Chs 08-11))

49:54

- Inference clear as day in this region of suspicion, that Mr. Barsad, still in the

まだin疑いのこの地域における日と明確な推論、氏Barsad、

バイオインフォマティクスと計算生物学の違い (Difference Between Bioinformatics and Computational Biology)

09:06

- Then comes a statistical inference.

そして、統計的推論が行われる。

- And here, we are taking the data from biological side and trying to create the inference.

そしてここでは、生物学的な側面からデータを取り、推論を行おうとしている。

NVIDIA CEO ジェンスン・フアン氏とMicrosoft Build 2025のサティア・ナデラ氏による対談 (Conversation with NVIDIA CEO Jensen Huang: Satya Nadella at Microsoft Build 2025)

12:36

- We did that through all kinds of things like in flight batching and speculative decoding and all kinds of new algorithms that sit underneath the inference engine.

これは、インフライトバッチングやスペキュラティブデコーディング、そして推論エンジンの下にある様々な新しいアルゴリズムなど、あらゆる種類のことを通じて実現しました。

インプットは「理解可能」でなければならないのか? (Does Input Have to Be "Comprehensible"?)

14:36

- Then you can probably make the inference, oh, the word ball probably means ball.

それなら、ボールという単語はおそらくボールを意味するのだろう、と推論できるだろう。

黃仁勳談數據處理與生成式ai的未來 (黃仁勳談數據處理與生成式AI的未來)

24:54

- We recently turned LLAMA 3 into a fully containerized inference microservice.

我々は最近、LLAMA 3を完全にコンテナ化された推論マイクロサービスにした。

- And so we created this thing called the NVIDIA Inference Microservice, where we package up all of the dependencies, we optimize all of it, we have a factory in the company with all these engineers working, who are expert in doing this, and we package it up into a microservice, and you could enjoy it at Databricks.

そこで私たちは、NVIDIA Inference Microserviceと呼ばれるものを作りました。依存関係をすべてパッケージ化し、すべてを最適化し、これを行うエキスパートであるエンジニアが働いているファクトリーを社内に用意し、マイクロサービスにパッケージ化しました。