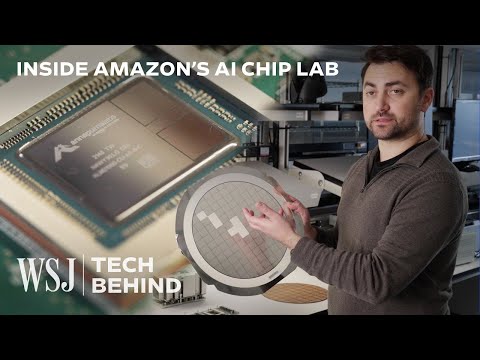

注目!新時代を切り開く「AIチップ」の製造現場に潜入!

林宜悉 が 2024 年 01 月 09 日 に投稿  この条件に一致する単語はありません

この条件に一致する単語はありませんUS /ˈprɑsˌɛs, ˈproˌsɛs/

・

UK /prə'ses/

- v.t.(コンピュータの)データを処理する;処理する;処理する;一連の工程を経る;加工する : 加工処理する;理解する

- n. (c./u.)手続き;一連の行為;方法;訴訟手続き;プロセス (コンピューター)

US /ɪˈsɛnʃəl/

・

UK /ɪ'senʃl/

US /ˈtɪpɪklɪ/

・

UK /ˈtɪpɪkli/

US /ˈɪnstəns/

・

UK /'ɪnstəns/

- n. (c./u.)例;発生;インスタンス

- v.t.例に挙げる

- phr.要請で

エネルギーを使用

すべての単語を解除

発音・解説・フィルター機能を解除