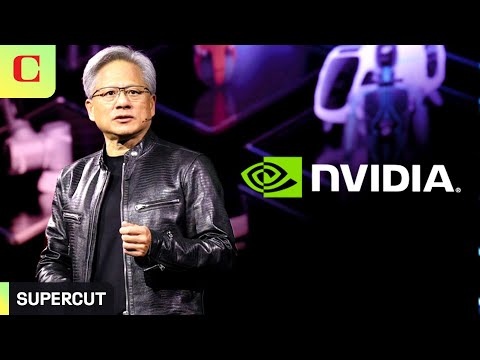

Nvidiaの2024年Computex基調講演:15分ですべてが明らかになる (Nvidia's 2024 Computex Keynote: Everything Revealed in 15 Minutes)

VoiceTube が 2024 年 06 月 06 日 に投稿  この条件に一致する単語はありません

この条件に一致する単語はありませんUS /ɪnˈkrɛdəblɪ/

・

UK /ɪnˈkredəbli/

- adv.信じられないことに;信じられないほど;信じられないほど;驚くほど

US /ɪnˈkrɛdəbəl/

・

UK /ɪnˈkredəbl/

- adj.信じられない;すばらしい;信じられない;信じられない

US /ˈprɑsˌɛs, ˈproˌsɛs/

・

UK /prə'ses/

- v.t.(コンピュータの)データを処理する;処理する;処理する;一連の工程を経る;加工する : 加工処理する;理解する

- n. (c./u.)手続き;一連の行為;方法;訴訟手続き;プロセス (コンピューター)

US /ˈmʌltəpəl/

・

UK /ˈmʌltɪpl/

- adj.複数の;多様な;多発性の;多重の

- n. (c.)倍数;多数;倍率

- pron.多数

エネルギーを使用

すべての単語を解除

発音・解説・フィルター機能を解除