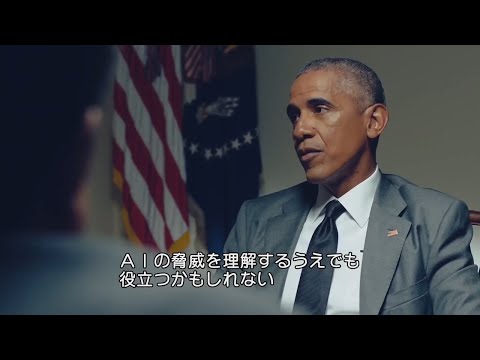

AI時代の国家のセキュリティとは? | バラク・オバマ×伊藤穰一 | Ep3 | WIRED.jp

林宜悉 が 2020 年 08 月 06 日 に投稿  この条件に一致する単語はありません

この条件に一致する単語はありません- n. (c./u.)集まり;仲間

- v.t.まとまる

- v.t./i.束ねられる

US /səˈfɪstɪˌketɪd/

・

UK /səˈfɪstɪkeɪtɪd/

- adj.話をより複雑にする;洗練された

- v.t.洗練させた

- v.t./i.出場する;計算する;思う;思う

- n.姿 : 体形;数字;人物像;図表;著名人;姿の輪郭;数字

エネルギーを使用

すべての単語を解除

発音・解説・フィルター機能を解除