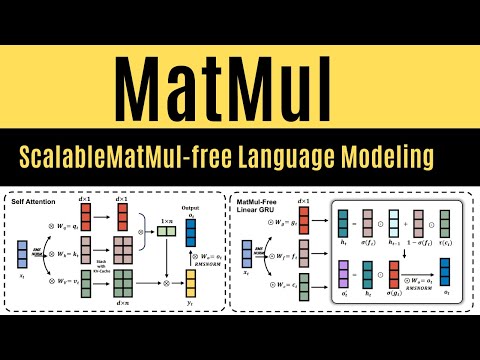

MatMulフリー言語モデリングとは (What is MatMul-free Language Modeling)

a0912556613 が 2024 年 06 月 24 日 に投稿  この条件に一致する単語はありません

この条件に一致する単語はありませんUS /səˈner.i.oʊ/

・

UK /sɪˈnɑː.ri.əʊ/

US /ˈprɛznt/

・

UK /'preznt/

- adj.出席している;現在

- n.プレゼント;現在時制;現在;贈り物

- v.t.紹介する;司会をする;発表する;提示する;(賞を)贈呈する

- v.i.現れる

- n. (c./u.)~へ行く手段;利用する機会;アクセス

- v.t.利用可能である : 使用許可を得る

- v.t./i.アクセス;アクセスする

エネルギーを使用

すべての単語を解除

発音・解説・フィルター機能を解除